Amazon Elastic Inference 출시 – GPU 기반 딥러닝 추론 가속 서비스 (서울 리전 포함)

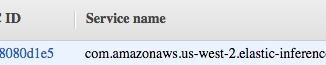

Amazon Elastic Inference 출시 – GPU 기반 딥러닝 추론 가속 서비스 (서울 리전 포함) 최근 인공 지능과 딥러닝이 발전한 이유 중 하나로 GPU(그래픽 처리 장치)의 환상적인 컴퓨팅 성능을 꼽을 수 있습니다. 약 10년 전 연구자들은 기계 학습과 고성능 컴퓨팅에 대규모 하드웨어 병렬 처리를 활용하는 방법을 찾아냈습니다. 관심 있는 분들은 2009년 스탠포드 대학이 발표한 논문(PDF)을 살펴보시기 바랍니다. 현재 GPU는 개발자와 데이터 과학자들이 의료 영상 분석이나 자율 주행을 구현하기 위해 복잡한 모델에 방대한 데이터 세트를 훈련시키는 데 도움을 줍니다. 예를 들어 Amazon EC2 P3 제품군에서는 최대 8개의 NVIDIA V100 GPU를 동일한 인스턴스에 사용하여 최대 1PetaFLOP의 혼합 정밀도 성능을 실현할 수 있습니다. 이는 불과 10년 전 당시로서는 역사상 가장 빠른 슈퍼컴퓨터의 성능과 같은 수준입니다. 물론 모델을 학습시키기만 한다고 끝나는 것은 아닙니다. 즉, 모델을 작업에 투입하고 새로운 데이터 샘플의 결과를 예측하는 방법도 찾아야 합니다. 불행히도 개발자들은 인스턴스 유형과 크기를 선택할 때 어려움을 겪는 경우가 [ more… ]