Amazon SageMaker 섀도우 테스트 기능 – ML 모델 변형 간 추론 성능 비교

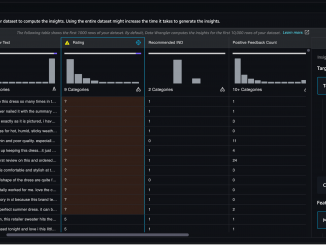

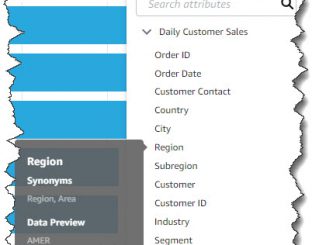

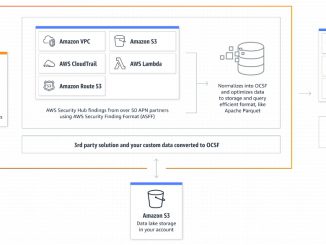

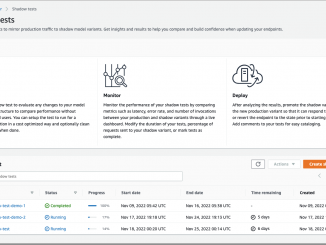

Amazon SageMaker 섀도우 테스트 기능 – ML 모델 변형 간 추론 성능 비교 기계 학습(ML) 워크로드를 제작 환경으로 옮길 때에는 배포 모델을 지속적으로 모니터링하고, 모델 성능의 편차가 발견되면 이를 처음부터 다시 수행해야 합니다. 신규 모델을 구축할 때는 일반적으로 기간별 추론 요청 데이터를 사용하여 오프라인에서 모델 검증을 시작합니다. 그러나 이 데이터는 때때로 현재의 실제 상황을 설명하지 못합니다. 예를 들어 제품 추천 모델에서 아직 보지 못한 신제품이 트렌드가 될 수 있습니다. 아니면, 사용자가 이전에 모델을 노출한 적이 없는 제작 환경에서 추론 요청의 양이 갑자기 급증하는 것을 경험할 수도 있습니다. 오늘 저는 Amazon SageMaker의 섀도우 테스트 지원을 발표하게 되어 매우 기쁩니다! 섀도우 모드에서 모델을 배포하면 제작 모델에 대한 실시간 추론 요청의 사본을 신규(섀도우) 모델로 라우팅하여 보다 총체적인 테스트를 수행할 수 있습니다. 하지만 제작 모델의 응답만 호출 애플리케이션에 반환됩니다. 섀도우 테스팅은 모델에 대한 신뢰도를 높이고 잠재적 구성 오류와 성능 문제가 최종 사용자에게 영향을 미치기 [ more… ]